Marketing

Confidentialité des données et IA : est-ce que ChatGPT est sûr ?

Marketing

C’est nouveau. C’est révolutionnaire. Et ça fait un peu peur. Non, il ne s’agit pas d’un énième reboot hollywoodien, mais bien d’intelligence artificielle (IA), de la politique de protection des données de ChatGPT, et de la façon dont ces nouveaux outils bouleversent les industries et amènent les personnes, les entreprises et les gouvernements à s’interroger sur la sécurité et la confidentialité des données et informations personnelles.

Ces puissants robots conversationnels possèdent un potentiel que même leurs créateurs ont sous-estimé. Comme vous le verrez, des personnes et des entreprises du monde entier s’interrogent déjà sur les risques en matière de sécurité des données liés à l’IA et à ChatGPT. Dans quelle mesure vos données sont-elles sécurisées lorsque vous utilisez ces outils ? Et comment garder le contrôle et la sécurité de vos informations, le cas échéant ?

Dans ce tour d’horizon, nous examinerons les différentes préoccupations en matière de protection des données et de confidentialité liées à ChatGPT et aux outils d’IA tels que Bard de Google et Bing de Microsoft, la manière dont le monde s’adapte à leur essor soudain et ce à quoi nous pouvons nous attendre dans les mois et les années à venir.

ChatGPT, développé par OpenAI, a été lancé fin 2022 et rassemble plus de 100 millions d’utilisateurs après quelques mois d’exploitation seulement, ce qui est de loin l’avancée la plus rapide d’une nouvelle technologie à laquelle nous ayons assisté depuis longtemps.

Contrairement aux moteurs de recherche traditionnels, ChatGPT est un chatbot d’IA : un utilisateur pose des questions, et l’outil y répond comme le ferait un être humain, mais plus rapidement. Vous pouvez lui demander de rédiger un email, de proposer dix lignes d’objet ou des CTA, de rédiger des publications pour les réseaux sociaux, de créer des structures d’articles de blog et bien plus encore. Il peut également écrire du code informatique, créer des poèmes et des charades, et résumer des notes de réunions.

Comment cet outil parvient à tout cela ? ChatGPT a été formé à partir de la quasi-totalité des données disponibles en ligne – sites web, publications sur les réseaux sociaux, livres, données gouvernementales et plus encore (jusqu’en septembre 2021, en tout cas). L’outil utilise cette masse de données pour traiter les réponses à vos questions et demandes, mais n’est pas capable pour l’instant d’accéder aux données en temps réel comme le ferait un moteur de recherche.

Mais qu’en est-il si certaines des données fournies à ChatGPT ne sont pas destinées à un usage public ? OpenAI a-t-elle le droit d’utiliser vos données sensibles comme elle le souhaite, simplement parce que vous avez posté quelque chose en ligne il y a cinq ans ? Et qu’en est-il des informations que vous donnez directement à ChatGPT dans le cadre de votre interaction avec cet outil ?

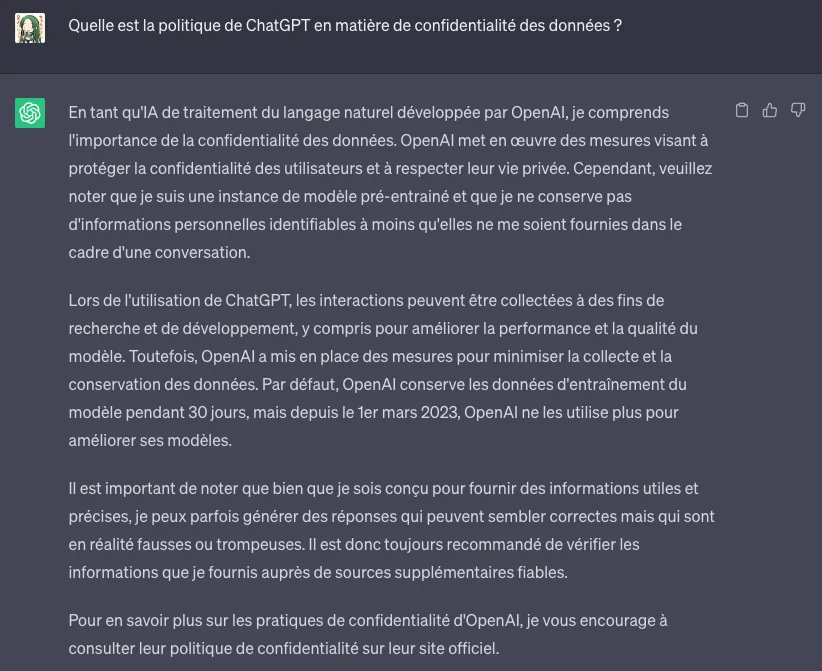

Qui mieux que ChatGPT peut répondre à cette question ?

Selon la politique de confidentialité de ChatGPT, l’outil collecte les données des utilisateurs à partir de trois endroits :

Rien ne semble vraiment différer de la collecte de données effectuée par la plupart des autres sites web, et les réseaux sociaux se battent depuis des années contre ces questions de confidentialité.

La politique de ChatGPT indique également que l’outil peut partager ces données avec des fournisseurs, des prestataires de services, des entités juridiques, des affiliés et ses propres formateurs en IA. Toutefois, si les utilisateurs de ChatGPT choisissent expressément de ne pas le faire, l’entreprise ne partagera pas d’informations d’identification telles que les numéros de sécurité sociale ou les mots de passe.

Ainsi, en théorie, si ce que vous écrivez dans le chatbot peut être utilisé par l’outil de manière incontrôlable ou inimaginable, il y a peu de chances que cela remonte jusqu’à vous. Comment OpenAI gère-t-elle cela ? Selon la politique de l’entreprise, après une période de conservation, les données de votre chat sont anonymisées en vue d’une utilisation ultérieure, voire supprimées dans un soucis de confidentialité s’il s’agit de données personnelles.

Mais tout se complique face à la difficulté de définir le terme « personnel ». Qu’en est-il des questions médicales ? Quid des informations sur les entreprises qui peuvent être introduites dans le chatbot ? Les individus peuvent entrer des informations dans ChatGPT sans se rendre compte qu’elles pourraient rendre public un contenu qui devrait rester privé.

Pour répondre à cette préoccupation croissante, en mai 2023, OpenAI a ajouté une fonction qui permet aux utilisateurs d’activer un paramètre pour empêcher les formateurs de l’entreprise et leurs modèles d’IA d’utiliser leurs entrées ChatGPT comme données d’entraînement. ChatGPT étant conçu pour apprendre au fur et à mesure, l’utilisation de cette fonction par les utilisateurs permet de limiter ses capacités.

En outre, les utilisateurs peuvent également se faire envoyer par email l’historique de leur échange avec ChatGPT, qui leur montre toutes les informations qu’ils ont soumises au chatbot jusqu’à présent.

Lorsque les fonctions d’autocomplétion sont apparues, les risques liés à la protection des données ont alarmé les premiers utilisateurs – par exemple, les personnes commençaient à taper leur numéro de sécurité sociale et pouvaient voir l’ordinateur le compléter.

Si tout ce que vous lui soumettez fait partie de sa base de données, les informations que vous entrez dans ChatGPT pourraient apparaître comme une réponse d’IA générative pour n’importe qui d’autre. Et bien que cela puisse sembler inoffensif et, dans de nombreux cas, le soit, que se passe-t-il si un employé d’une entreprise saisit des notes d’une réunion et demande à ChatGPT de les résumer et de les éditer ? ChatGPT possède désormais des informations confidentielles sur cette entreprise, ses produits ou ses clients.

Supposons qu’un parent ou un ami demande à ChatGPT de suggérer des idées de cadeaux d’anniversaire pour quelqu’un d’autre et qu’il indique la date de naissance dans sa demande. ChatGPT connaît alors la date de naissance de cette personne. Encore une fois, OpenAI affirme que ChatGPT ne partage pas les informations personnelles et les filtre dans sa base de données.

Cette préoccupation a néanmoins conduit plusieurs grandes entreprises – dont Amazon, JP Morgan, Verizon, Apple et Accenture – à interdire à leurs employés d’utiliser ChatGPT dans le cadre de leurs activités professionnelles.

« Pour l’heure, de nombreuses incertitudes subsistent sur la façon dont les grands modèles de langage comme ChatGPT traitent les informations personnelles, ainsi que sur les risques de cybersécurité qui peuvent en découler. La façon dont les systèmes d’IA utilisent et stockent les données entrées, et la façon dont ces données sont protégées d’éventuelles fuites, failles de sécurité et mauvais acteurs, restent très floues. Le processus de suppression ces données une fois qu’elles ont été entrées est également ambigu. Il n’est donc pas étonnant de voir des entreprises partout dans le monde publier des politiques spécifiques sur la façon dont leurs employés peuvent utiliser ces outils. »

Darine Fayed, vice-présidente, responsable juridique EMEA – Sinch

Une autre préoccupation concerne non seulement l’utilisation de vos informations personnelles dans le cadre du logiciel d’IA de ChatGPT, mais aussi leur exactitude.

Nous avons le « droit à l’oubli », affirme un critique, mais est-ce possible avec ce que ChatGPT sait déjà de nous ? Et si ce qu’il pense savoir de nous n’est pas vrai, comment corriger les erreurs ?

« Les systèmes d’intelligence artificielle comme ChatGPT nécessitent d’énormes quantités de données. Cela signifie que, parfois, pour les personnes développant ces systèmes, l’acquisition de ces données prime sur le respect des réglementations sur le respect et la protection de la vie privée. Malgré la mise en place d’outils permettant le retrait automatique des informations sensibles, des informations personnelles peuvent subsister. »

Frédéric Godin, responsable de l’IA – Sinch Engage

Nous avons fait le test en demandant à ChatGPT de nous parler de l’un de nos auteurs. Nous avons tapé

Qui est [prénom nom] de [ville]

L’IA a prétendu que cette personne travaillait pour un journal pour lequel elle n’avait en fait jamais travaillé. Elle a tiré cette conclusion erronée parce que l’auteur avait écrit quelques articles non rémunérés pour ce journal. ChatGPT ne propose aucun mécanisme pour corriger cette erreur. Ces informations inexactes peuvent conduire à des problèmes d’emploi, de harcèlement et de partialité, le tout basé sur quelque chose qui n’est pas vrai.

À quel point cela est un problème pour ChatGPT ? Que se passe-t-il si quelqu’un commence délibérément à écrire de fausses informations sur quelqu’un d’autre et le fait de manière répétée ?

L’Union européenne a fait avancer la cause de la protection de la confidentialité des emails et des données des consommateurs en publiant le Règlement général sur la protection des données (RGPD). Ce règlement européen stipule clairement que vous ne pouvez tout simplement pas prendre les données des personnes et les utiliser comme bon vous semble – même s’ils les publient en ligne.

Les marketeurs par email du monde entier se sont déjà adaptés pour protéger la confidentialité dans le cadre de leurs efforts de personnalisation des emails. Ils ont également dû s’efforcer de comprendre des réglementations parfois obscures lorsque plusieurs juridictions sont en jeu – comme les réglementations sur la confidentialité des emails entre l’UE et les États-Unis.

Aujourd’hui, les gouvernements, institutions et entreprises partout dans le monde commencent à s’intéresser à la manière dont ces technologies émergentes protègent les données à caractère personnel, et aux mesures à prendre sur l’accès de ces technologies aux informations sensibles.

« À mesure que les aspects révolutionnaires des technologies d’IA sont compris par tout le monde, l’intérêt sur la confidentialité des données traitées par l’IA croît. Par exemple, Microsoft crée désormais des API ChatGPT à l’attention des développeurs, et les met à disposition dans les centres de données européens afin de respecter les lois relatives au RGPD. Nous observons également un intérêt accru pour les questions liées à la vie privée dans les communautés open source travaillant au développement de solutions libres concurrentes de ChatGPT. Un changement similaire a également eu lieu avec des outils de texte génératif moins connu comme Github Copilot, qui crée du code pour les développeurs. »

Frédéric Godin, responsable de l’IA – Sinch Engage

Même aux États-Unis, où la confidentialité des données n’est généralement pas une préoccupation du gouvernement fédéral ou des grandes entreprises, l’essor de l’IA a suscité des inquiétudes. En mars, plus de 1 800 experts – notamment issus de certains géants américains de la technologie – ont signé une lettre ouverte demandant une mise en pause de six mois de l’entraînement des modèles de langages importants pour permettre à toutes les parties prenantes de développer conjointement des protocoles de sécurité partagés.

L’administration fédérale a également demandé l’avis des citoyens sur les réglementations potentielles liées à l’IA. Dans un récent communiqué de presse, la National Telecommunications and Information Administration (NTIA) a déclaré : « Le président Biden a clairement indiqué qu’en matière d’IA, nous devons à la fois soutenir l’innovation responsable et mettre en place des garde-fous appropriés pour protéger les droits et la sécurité des Américains ».

À la mi-mai 2023, Sam Altman, le PDG d’OpenAI, participait à une audition du Congrès américain sur l’intelligence artificielle. Bien qu’aucune décision n’ait été prise durant cette première audition, les sénateurs se sont mis d’accord sur la nécessité de mettre en place des garde-fous pour réguler l’utilisation des outils d’IA. Ils ont par ailleurs souligné qu’il était important de prendre ces mesures afin de ne pas répéter certaines erreurs faites lors des débuts des réseaux sociaux.

Entre autres choses, les inquiétudes concernant les règles de confidentialité de ChatGPT ont conduit l’Italie à demander à OpenAI de cesser d’utiliser les données personnelles des citoyens italiens dans le cadre de son algorithme de formation. OpenAI a réagi en cessant d’offrir ses services à l’Italie pendant la durée de l’enquête. L’Italie liste quatre préoccupations principales concernant le ChatGPT :

L’autorité italienne de protection des données personnelles, la Garante per la Protezione dei Dati Personali, a fait valoir qu’il n’existait « aucune base juridique » pour l’utilisation des données à caractère personnel afin d’« entraîner » l’algorithme d’intelligence artificielle de ChatGPT. Les personnes qui ont mis leurs informations en ligne n’ont jamais consenti ou imaginé qu’elles seraient utilisées comme ensembles de données pour entraîner un système d’IA à répondre à des questions provenant du monde entier. Ne devraient-elles pas avoir leur mot à dire ?

Ce n’est que lorsqu’OpenAI a répondu de manière satisfaisante aux demandes des régulateurs, fin avril, que l’Italie a rétabli l’utilisation de ChatGPT à l’intérieur de ses frontières.

Toujours en avril 2023, la France a commencé à enquêter sur l’utilisation par ChatGPT des données à caractère personnel de ses ressortissants à la suite de plusieurs plaintes.

En conséquence, la Commission nationale de l’informatique et des libertés (CNIL) a publié un plan d’action sur l’intelligence artificielle en mai pour répondre à ces préoccupations.

L’Espagne est un autre pays européen qui a fait part de ses inquiétudes. En avril, l’agence espagnole de protection des données, l’Agencia Española de Protección de Datos (AEPD), a demandé au Comité européen de protection des données (CEPD) d’ouvrir une enquête sur les questions de vie privée liées au logiciel d’intelligence artificielle.

Simultanément, l’Espagne a ouvert une enquête sur OpenAI pour une « possible violation » de la réglementation sur la protection des données.

Mais les entreprises traditionnelles et les gouvernements ne sont pas les seuls à s’exprimer sur les questions de protection de la confidentialité liées à ChatGPT.

Les artistes, les créateurs de contenu et les sociétés de médias, dont les moyens de subsistance dépendent entièrement de la propriété de leurs œuvres et du contenu qu’ils produisent, s’inquiètent de voir les IA utiliser leur travail.

Le numéro du 29 mars 2023 du Hollywood Reporter aborde les préoccupations relatives au développement et à l’écriture de scripts par ChatGPT, ainsi qu’à la création d’images de personnes générées par des outils comme DALL-E.

Les images générées par IA gagnent en popularité et inquiètent les artistes

Si la créativité et la prise de décision humaines ne disparaîtront probablement pas totalement du processus créatif, l’un des principaux reproches faits est que l’IA générative utilise le travail de vrais artistes pour créer le sien, sans rémunérer ces artistes. En d’autres termes, ChatGPT ne pourrait pas « écrire » des scénarios ou de la poésie s’il ne disposait pas d’une gigantesque base de données provenant d’artistes réels.

Le droit d’auteur est une forme de protection des données. Il indique qu’une personne ou une entreprise est propriétaire d’un contenu et qu’elle dispose de droits spécifiques, pouvant faire l’objet d’une licence, associés à cette propriété. Mais avec ChatGPT et d’autres outils d’intelligence artificielle comme DALL-E, il est devenu beaucoup plus difficile de définir et d’attribuer la propriété. C’est pourquoi les outils d’IA sont devenus un point de discorde dans les négociations syndicales, notamment avec la Writer’s Guild of America (syndicat des scénaristes américains).

Qu’en pense Mailjet ? Comme vous pouvez le constater, les préoccupations relatives à ChatGPT et à la protection des données liées à l’IA vont bien au-delà de l’email, bien que nous soyons totalement concernés car ChatGPT peut être utilisé par les marketeurs pour améliorer ou rationaliser leur travail.

Nous prévoyons qu’avec une préoccupation mondiale accrue pour la confidentialité des données, et avec les gouvernements de l’UE et les géants de la technologie en tête, il est probable que les outils d’IA tels que ChatGPT seront contraints par de nouvelles lois et réglementations sur la protection de la vie privée d’incorporer des fonctions de confidentialité supplémentaires pour protéger leurs utilisateurs.

L’ajout récent d’un bouton qui leur permet de ne pas intégrer leurs informations sensibles dans l’algorithme de ChatGPT n’est probablement que le premier d’une longue série de changements de ce type à venir.

« Une croissance exponentielle implique une responsabilisation accrue. Je pense que nous verrons émerger des modèles hybrides de ChatGPT, dans lesquels il sera très simple de de supprimer des données spécifiques sur demande. Aujourd’hui, ces procédures restent très compliquées à effectuer avec les versions entraînées de l’outil. Mais par le passé, nous avons vu certains géants de la tech (les moteurs de recherche, par exemple) mettre en place des fonctionnalités permettant aux utilisateurs d’exercer leur droit à l’oubli. Ce n’est qu’une question de temps avant que ces questions ne soient également embrassées par ChatGPT. »

Frédéric Godin, responsable de l’IA – Sinch Engage

Comme toute autre entreprise qui souhaite développer son activité au sein de l’UE, OpenAI devra adapter la manière dont elle traite les données à caractère personnel des citoyens européens aux lois européennes relatives à la protection de la vie privée.

Vous souhaitez être informé des dernières actualités en matière de protection de la confidentialité ? Abonnez-vous à notre newsletter pour en savoir plus sur l’impact des réglementations sur les données personnelles sur votre stratégie marketing.

Envoyez-moi la newsletter. Je comprends qu’en m’abonnant, je choisis explicitement de recevoir la newsletter et que je peux facilement et à tout moment me désinscrire.

Comment le monde s’adapte-t-il à l’essor soudain d’outils d’IA tels que ChatGPT ?